时间:2024-08-08 来源:网络搜集 关于我们 0

英伟达 A100 Tensor核心GPU凭借其卓越的性能和先进的架构设计,成为AI推理和深度学习的加速关键。以下是对NVIDIA A100在这些领域中的详细分析,探讨其如何推动AI和深度学习应用的发展。

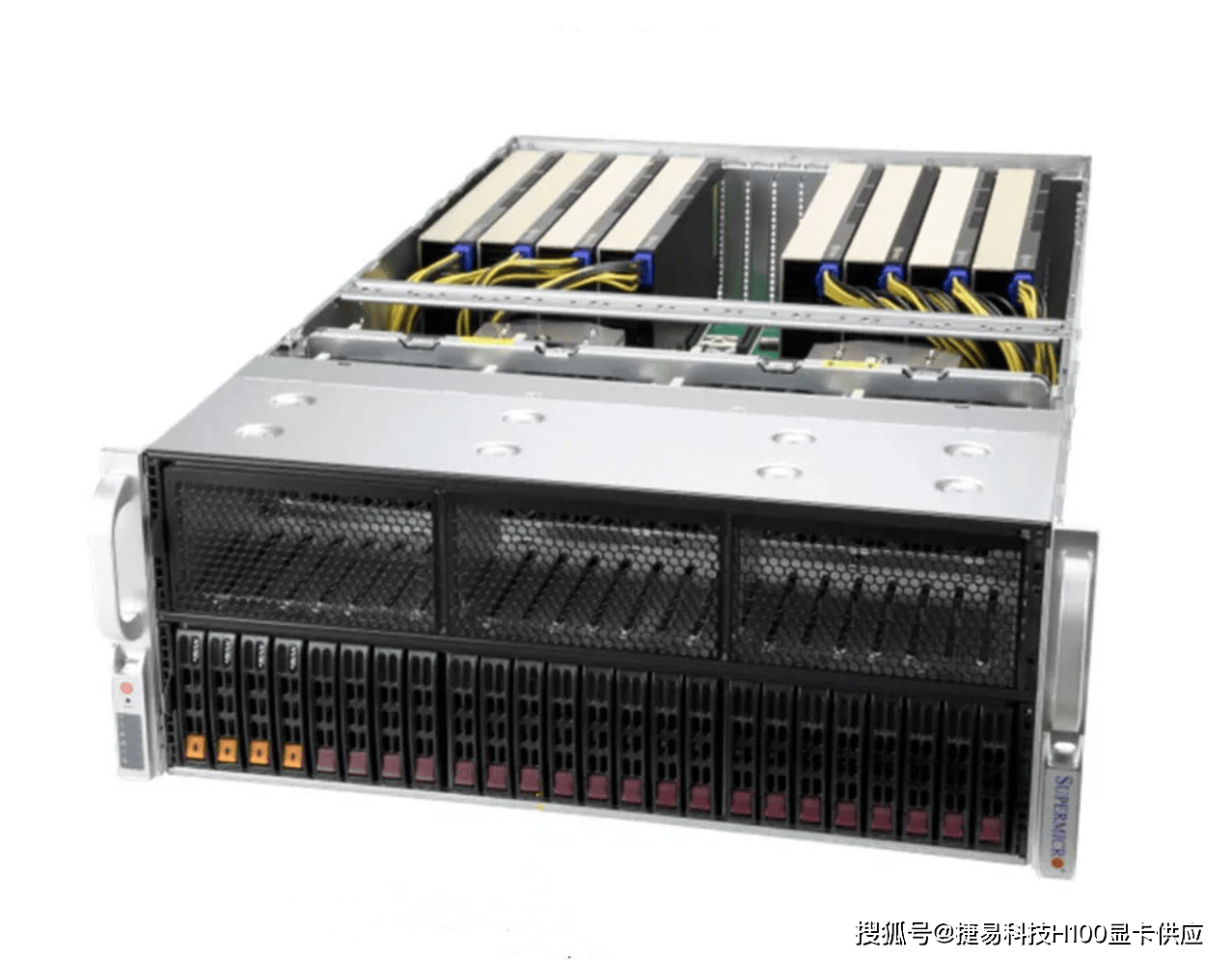

英伟达A100 服务器

英伟达A100 服务器

一、技术特性与优势

NVIDIA A100基于Ampere架构,集成了多项创新技术,为AI推理和深度学习提供了强大的计算能力和灵活性。

第四代Tensor核心:

A100配备了第四代Tensor核心,支持多种计算精度(包括FP64、TF32、FP32、FP16、INT8和FP8),能够在保持高计算精度的同时,显著提升计算速度。这些核心专为加速深度学习和AI推理任务而设计。

高内存带宽和容量:

A100拥有高达2 TB/s的内存带宽和80 GB的HBM2e内存,能够处理大规模数据集和复杂计算任务,确保模型训练和推理过程的高效性。

多实例GPU(MIG)技术:

MIG技术允许将单个A100 GPU分割成最多七个独立的GPU实例,每个实例可以独立运行不同的任务。这样,不同的AI推理和深度学习任务可以在同一GPU上同时运行,提高资源利用率和任务处理效率。

NVLink互联:

A100支持NVIDIA NVLink技术,使多GPU系统能够实现高速数据传输和通信,增强多GPU集群的协同工作能力,进一步提升深度学习模型训练的效率。

英伟达A100 服务器

英伟达A100 服务器

二、AI推理加速

AI推理是将训练好的模型应用于实际数据,以获得预测或分类结果的过程。A100在以下方面显著加速了AI推理任务:

高效推理性能:

A100的Tensor核心和高内存带宽确保了在推理过程中,能够快速处理大规模数据,提供高吞吐量和低延迟的推理结果。

多模型并行推理:

利用MIG技术,A100可以在同一GPU上同时运行多个AI模型,实现并行推理,满足不同应用场景的需求。

混合精度推理:

A100支持多种计算精度,允许在推理过程中使用混合精度技术,在保证结果精度的同时,显著提升推理速度。

三、深度学习加速

深度学习模型的训练通常需要处理大量的数据和复杂的计算。A100显卡在以下方面加速了深度学习模型的训练:

快速模型训练:

A100的高计算性能和内存带宽使得深度学习模型的训练时间显著缩短。其Transformer引擎能够快速处理大型语言模型(如GPT-3、BERT)的训练任务。

大规模数据处理:

A100的高内存容量和带宽使其能够处理大规模数据集,支持更大规模的深度学习模型训练,提升模型的准确性和泛化能力。

多任务训练:

A100的MIG技术允许在同一GPU上同时训练多个模型,提高资源利用率和训练效率,适合多任务环境中的深度学习应用。

英伟达A100 服务器

英伟达A100 服务器

四、应用场景

NVIDIA A100显卡在AI推理和深度学习中的广泛应用,涵盖了多个行业和领域:

自然语言处理(NLP):

A100显卡在NLP任务中表现出色,适用于训练和推理大型语言模型(如GPT-3、BERT),提高文本生成、情感分析和机器翻译等应用的性能和效率。

计算机视觉:

在图像识别、物体检测和视频分析等计算机视觉任务中,A100显卡能够快速处理大量图像数据,加速模型训练和推理,提升图像处理的准确性和实时性。

推荐系统:

A100显卡通过加速深度学习算法,提升推荐系统的响应速度和准确度,为用户提供个性化的推荐服务,广泛应用于电商和内容平台。

医疗影像分析:

A100显卡在医疗影像分析中能够快速处理大规模的医学图像数据,支持疾病诊断、病灶检测和影像处理,提升医疗诊断的效率和准确性。

英伟达A100 服务器

英伟达A100 服务器

五、未来展望

随着AI和深度学习技术的不断发展,NVIDIA A100显卡将在以下几个方面继续发挥重要作用:

更大规模模型训练:

A100的强大计算能力将推动更大规模AI模型的训练和应用,如更高级的语言模型和复杂的神经网络。

边缘计算和IoT:

A100的MIG技术使其在边缘计算和物联网应用中具备极高的灵活性和效率,为边缘设备提供高效的AI计算支持。

绿色计算和可持续发展:

A100在提供高性能计算的同时,也注重能源效率和可持续发展,通过优化能源消耗和提升计算效率,为绿色计算和可持续发展做出贡献。

NVIDIA A100显卡凭借其卓越的计算性能和先进的技术设计,成为AI推理和深度学习的加速关键。无论是在自然语言处理、计算机视觉、推荐系统还是医疗影像分析领域,A100显卡都为用户提供了强大的技术支持和显著的性能提升。随着技术的不断进步和应用场景的扩展,NVIDIA A100显卡将在AI推理和深度学习中继续发挥重要作用,推动AI技术的创新和发展。返回搜狐,查看更多

责任编辑: